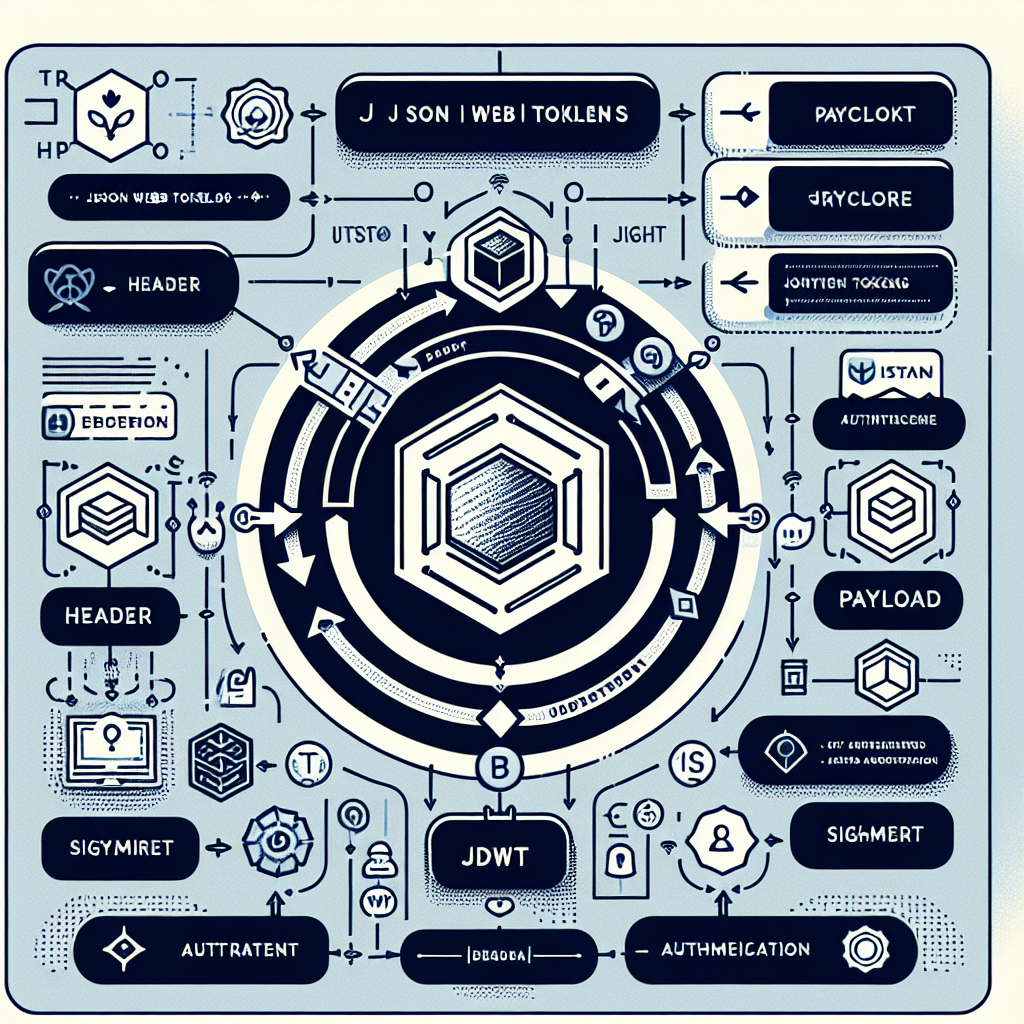

解釋 JSON 網路令牌 (JWT) - 一種安全且多功能的認證機制

在迅速演變的網路開發世界中,需要強大且安全的認證機制變得至關重要。JSON Web Tokens (JWT)已成為一種流行的解決方案,徹底改變了應用程式處理用戶認證的方式。在此博客文章中,我們將深入探討JWT的世界,探索它們的架構、好處、使用案例,以及最佳實踐方法。

1. 理解JWT:它們是什麼?

JSON Web Tokens,通常被簡稱為JWT,是用於在兩方之間安全地傳輸資訊的緊湊且URL安全的令牌。這些令牌以字串表示,且自我包含,意味著它們自身攜帶所有必要的資訊,無需伺服器端儲存。

2. JWT如何運作?

一個JWT由三部分組成,由點分隔:標頭、有效負載,以及簽名。這些部分都經過Base64Url編碼並連接以形成JWT。讓我們探討每一部分:

a. 標頭:標頭通常由兩部分組成:令牌的類型(JWT)和所使用的簽名演算法,例如HMAC SHA256或RSA。重要的是要注意,標頭並未加密,其目的是向收件人提供有關令牌的資訊。

b. 有效負載:有效負載包含聲明,這些聲明包含有關使用者及額外數據的語句。有三種類型的聲明:已註冊聲明、公共聲明,以及私人聲明。已註冊聲明包括如"iss"(發行者)、"exp"(到期時間)、"sub"(主題)等等的標準欄位。公共聲明可以由使用JWT的人定義,私人聲明旨在由事先同意的各方自定義。

c. 簽名:簽名由組合編碼標頭、編碼的有效負載,以及只有伺服器知道的秘密(或私鑰)生成。這可以確保令牌的完整性,並讓收件人確認令牌沒有被篡改。

3 . 使用JWT的好處

a. 無狀態:與傳統的基於session的認證系統不同,JWT是無狀態的。伺服器不需要儲存session資訊,這可以減少開銷並提高可擴展性。

b. 安全:JWT已簽名,確保內部的數據保持防篡改的。另外,它們可以進一步加密以提高安全性,雖然這是可選的。

c. 靈活性:JWT具有多功能性,不僅可以用於認證。它們可以攜帶任意數據,這使它們成為跨微服務分享用戶相關信息的理想選擇。

d. 跨域兼容性:JWT可以通過URL或HTTP請求的標頭輕鬆傳輸,使它們適用於單一簽入(SSO)情境。

4. 一般使用案例

JWT在各種情境下均有應用,包括:

a. 認證和授權:JWT主要用於安全地認證使用者並授予他們訪問特定資源或操作的許可。

b. 單次簽入(SSO):在SSO系統中,用戶以一次登入並獲得對多個應用程式的訪問權限,無需為每一個再次登入。JWT使這個過程無縫且安全。

c. 資訊交換:JWT可以用於在分散式應用程式架構的不同服務或微服務之間共享資訊。

5. JWT實施的最佳做法

a. 安全的密鑰管理:確保用於對JWT進行簽名的秘密得到充分保護。考慮使用非對稱演算法以增強安全性。

b. 令牌過期:為JWT設置較短的過期時間,以最小化風險窗口。

c. 避免敏感數據:避免在有效負載中存儲敏感資訊,因為JWT並未加密,可以輕易被解碼。

d. 令牌撤銷:在某些情況下,如使用的令牌被操縱時,你可能需要實施令牌撤銷機制,以在它們過期前使JWT失效。

結論

JSON Web Tokens已成為現代網路開發的基石,提供了一種安全且高效的認證和數據交換方式。通過理解JWT如何運作以及遵循最佳實踐,開發人員可以為他們的應用程式實施強大且可擴展的認證解決方案。隨著我們見證網路技術的進步,JWT無疑將繼續成為確保我們在線體驗的完整性和安全性的重要工具。