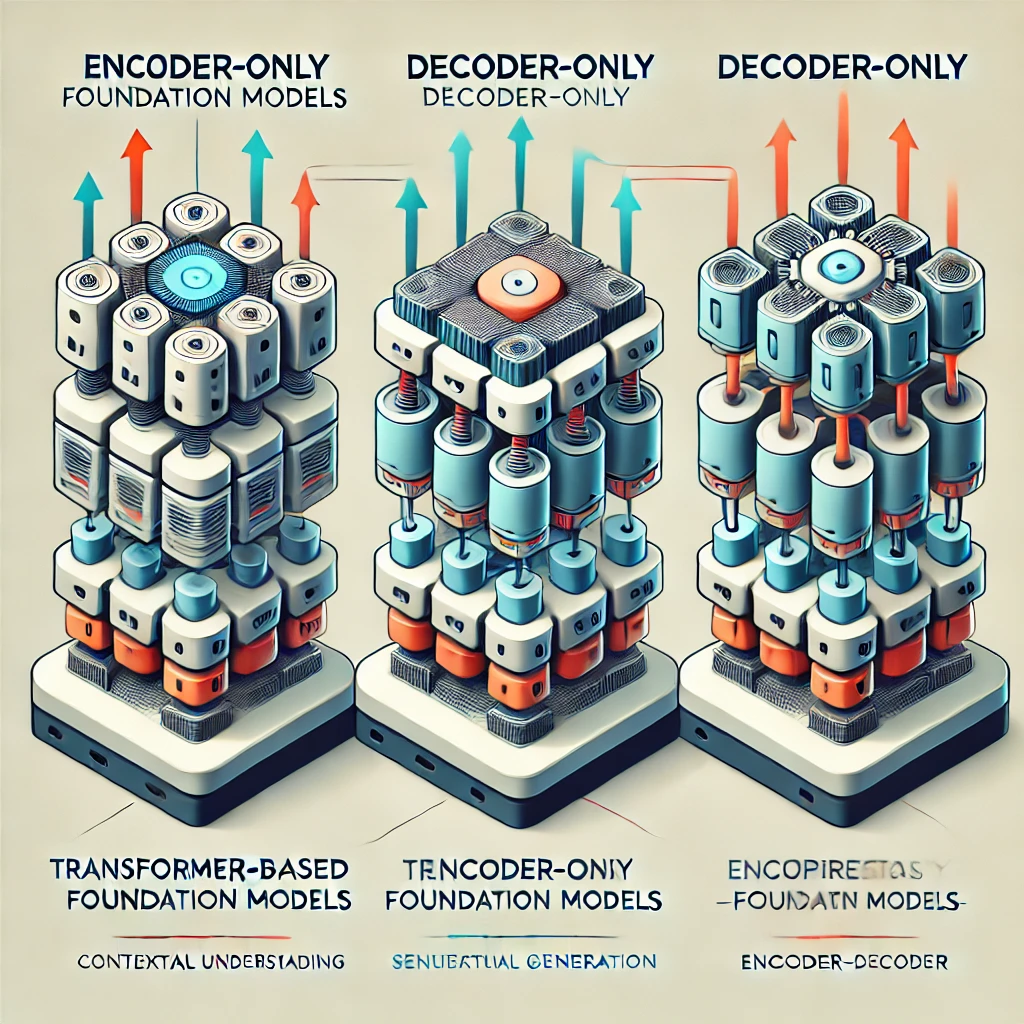

基於變壓器的基礎模型類型

基於變壓器的基礎模型已經革新了自然語言處理(NLP),並分為三種主要類型:只有編碼器,只有解碼器,和編碼器-解碼器模型。每種類型都使用特定的目標函數進行訓練,並適合不同類型的生成任務。讓我們深入了解每個變體,以及它們的獨特特性和應用。

只有編碼器模型 (自編碼器)

訓練目標: 遮罩語言模型 (MLM)

只有編碼器的模型,通常被稱為自編碼器,使用遮罩語言模型進行預訓練。這種技術涉及隨機遮罩輸入代幣,並訓練模型來預測這些遮罩代幣。通過這樣做,模型學會根據其前面和後面的代幣來理解代幣的上下文,這通常被稱為去噪目標。

特性

- 雙向表示:只有編碼器的模型利用雙向表示,使它們能夠理解句子中代幣的全文本。

- 嵌入使用:這些模型生成的嵌入非常有效,適用於需要理解文本語義的任務。

應用

- 文本分類:這些模型對於需要理解文本上下文和語義的文本分類任務非常有用。

- 語義相似性搜索:只有編碼器的模型可以提供超越簡單關鍵詞匹配的先進文件搜索算法,提供更準確和相關的搜索結果。

例子: BERT

只有編碼器模型的一個著名例子是BERT (來自變壓器的雙向編碼器表示)。BERT捕獲上下文信息的能力使其成為各種NLP任務的強大工具,包括情感分析和命名實體識別。

只有解碼器模型 (自回歸模型)

訓練目標: 因果語言模型 (CLM)

只有解碼器的模型,或自回歸模型,使用單向因果語言模型進行預訓練。在這種方法中,模型僅使用前面的代幣來預測序列中的下一個代幣,確保每次預測都僅基於到目前為止可用的信息。

特性

- 單向表示:這些模型通過一次預測一個代幣生成文本,使用之前生成的代幣作為上下文。

- 生成能力:它們非常適合生成任務,可以產生連貫並與上下文相關的文本輸出。

應用

- 文本生成:自回歸模型是需要文本生成的任務的標準,如聊天機器人和內容創建。

- 問答:這些模型擅長根據給定的提示生成精確且與上下文相關的問答。

例子: GPT-3, Falcon, LLaMA

解碼器模型的顯著例子包括GPT-3, Falcon與LLaMA。這些模型因其生成人類文本的能力和以高精確度執行各種NLP任務而得到廣泛認可。

編碼器-解碼器模型 (序列至序列模型)

訓練目標: 範圍損壞

編碼器-解碼器模型,通常被稱為序列至序列模型,利用了變壓器架構的編碼器和解碼器組件。這些模型的常見預訓練目標是範圍損壞,其中連續的代幣範圍被遮罩,並訓練模型重建原始序列。

特性

- 雙組件:這些模型使用編碼器處理輸入序列,並使用解碼器生成輸出序列,使它們非常靈活。

- 上下文理解:通過利用編碼器和解碼器,這些模型可以有效地翻譯,概括和生成文本。

應用

- 翻譯:序列至序列模型的原始設計用於翻譯任務,在保留意義和上下文的同時,將文本從一種語言轉換為另一種語言。

- 文本總結:這些模型也非常有效於將長文本總結為簡潔且信息豐富的總結。

例子: T5, FLAN-T5

T5模型(文本至文本轉換變壓器)和其微調版本FLAN-T5,是編碼器-解碼器模型的知名例子。這些模型已成功應用於各種生成語言任務,包括翻譯,概括和問答。

總結

總的來說,基於變壓器的基礎模型分為三種不同的類型,每種都有獨特的訓練目標和應用:

- 只有編碼器模型 (自編碼):最適合進行文本分類和語義相似性搜索的任務,BERT是其主要範例。

- 只有解碼器模型 (自回歸):非常適合生成任務,如文本生成和問答,其例子包括GPT-3, Falcon和LLaMA。

- 編碼器-解碼器模型 (序列至序列):在翻譯和總結任務中擅長的多功能模型,由T5和FLAN-T5等模型代表。

理解每種變體的優點和應用有助於選擇特定NLP任務的適當模型,發揮變壓器架構的全部潛力。